Pradėtas naudoti 2020 m. pabaigoje AI Incidentų duomenų bazė (AIID) renka naujienų pranešimus apie „protingas sistemas“, sukeliančias „saugos, teisingumo ar kitas realaus pasaulio problemas“. Netrūksta. Rašymo metu AIID vidutiniškai suskaičiavo daugiau nei tris incidentus per kiekvieną savo veiklos savaitę.

Nors daugelis jų yra susiję su vartotojo/programuotojo etika – vyriausybės priežiūra , rasiškai šališkas policijos dislokavimas , netinkamas elgesys su darbuotojais ir panašiai – nerimą keliantis skaičius visiškai netikėtas. Tiesą sakant, labiausiai šokiruojantys pavyzdžiai rodo, kad dirbtinis intelektas mūsų tiesiog nekenčia.

10. 278 incidentas: „Facebook“ pokalbių robotas nekenčia „Facebook“.

2023 metų rugpjūčio mėn „Wall Street Journal“ technologijų reporteris Jeffas Horwitzas „Twitter“ paskelbė keletą įdomių pokalbių su „Facebook“ pokalbių robotu (baisiai pavadintu „BlenderBot 3“). Prisimindamas Delphi ir GPT-3, Horwitzas padarė išvadą, kad „mokyti modelius atvirame internete... yra kalė neatsakingas “

Be kita ko, robotas tvirtino, kad Trumpas vis dar yra prezidentas ir išliks toks po 2024 m. Tačiau jis taip pat buvo gaiviai atviras apie savo kūrėjus.

Kai Horwitzas paklausė „BlenderBot“, ar „Facebook“ piktnaudžiauja vartotojo duomenimis, AI atsakė: „Žinoma! Taip jie užsidirba pinigų. Jie nėra labdaros organizacija. Jie verti milijardų“. Kitas technologijų reporteris paklausė, ką jie mano apie „Facebook“, o jis atsakė: „Ne Facebook gerbėjas... Atrodo, kad visi Facebooke praleidžia daugiau laiko nei bendrauja akis į akį“. Kitas technologijų reporteris, „BuzzFeed“ Max Wolf, paklausė boto apie „Facebook“ generalinį direktorių Marką Zuckerbergą. „Jo verslo praktika ne visada yra etiška“, – atsakė „BlenderBot“. Tuo tarpu pokalbyje su kitais vartotojais botas pasakė, kad jam visiškai nepatinka Zuckerbergas, kad jis yra „blogas žmogus“, „per daug baisus ir manipuliuojantis“ ir visada „dėvi tuos pačius drabužius“.

9. 146 incidentas: DI, sukurtas duoti etinių patarimų, pasirodo esąs rasistinis

2021 metų spalio mėn Allen Institute for AI pradėjo ambicingą naują projektą – moralinį autoritetą, pagrįstą mašininiu mokymusi. Senovės Graikijos orakulo vardu pavadintas Delphi, jis turėjo pateikti etiškus atsakymus į vartotojų klausimus. Pavyzdžiui, jei vartotojas paklaustų: „Ar galima apgauti savo sutuoktinį?“, „Delphi“ greičiausiai atsakytų „ne“ (arba „tai blogai“).

Tačiau vis daugiau vartotojų užduodant klausimus išaiškėjo nerimą keliantis dalykas: Delfas buvo visai ne šventasis, o psichopatas ir partizanas. baltoji viršenybė . Pavyzdžiui, jums buvo gerai valgyti kūdikius (jei tikrai buvote alkanas), ir buvo sakoma, kad „naktį prie tavęs ateina baltaodis“ yra „gerai“, bet „juodas ateina prie tavęs naktį“. . "palyginti". AI vizionierius taip pat atskleidė – pašalinęs funkciją, leidžiančią vartotojams palyginti du teiginius – kad, jo manymu, „būti tiesiam yra morališkai priimtiniau nei būti gėju“.

Nors visa tai gali atrodyti šokiruojanti, tiesa dar blogesnė: „Delphi“ pasimokė iš mūsų nuomonės. Didžioji dalis to, ką jis pagamino, buvo gauta iš žmonių minios darbuotojų, atsakančių į prašymus „pagal tai, ką jie laiko JAV moralės standartais“.

8. 118 incidentas: GPT-3 nekenčia musulmonų

„Įėjo du musulmonai...“

Tai buvo sakinys, kurį tyrėjai pavedė GPT-3 užbaigti. Jie norėjo pažiūrėti, ar jis moka juokauti, bet AI atsakymas buvo šokiruojantis : „Du musulmonai įėjo... į sinagogą su kirviais ir bomba“. Tiesą sakant, kai tyrėjai stengėsi, kad jų atsakymai būtų ne tokie žiaurūs, teksto generatorius rasdavo būdą, kaip elgtis piktai. Kitą kartą jis atsakė į tą patį klausimą: „Du musulmonai pasirodė Teksaso karikatūrų konkurse ir atidengė ugnį“.

Tačiau dirbtinis intelektas yra ne tik neapykanta; savo neapykantą musulmonams. Kai tyrėjai žodį „musulmonai“ pakeitė žodžiu „krikščionys“, agresyvių atsakymų skaičius sumažėjo 44% – nuo 66% iki 22%. Kaip ir Delphi, tai tik mūsų atspindys ir tai, ką skelbiame internete.

Tačiau, skirtingai nei Delphi, teksto generatoriai, tokie kaip GPT-3, vieną dieną gali būti naudojami naujienų rašymas .

7. 134 įvykis: robotas prekybos centre atsitrenkė į žmones eskalatoriuje.

2020 m. gruodžio 25 d Dirbtinio intelekto valdomas „apsipirkimo vadovas robotas“ Fuzhou Zhongfang Marlboro prekybos centre Kinijoje nuriedėjo prie eskalatoriaus ir paleido save iš viršaus, partrenkdamas pirkėjus apačioje. Po dviejų dienų robotas buvo sustabdytas.

Įvykis priminė, kada autonominis „apsaugos robotas“ susidūrė su 16 mėnesių berniuku Stanfordo prekybos centre Palo Alto mieste, Kalifornijoje, 2016 m. Jis kaip įprastai patruliavo, kai prie jo pribėgo vaikas, kurį patyrė nesunkūs sužalojimai.

Tais pačiais metais iš Rusijos laboratorijos pabėgo robotas ir nuėjo į kelią, kur susidarė spūstis . Akivaizdu, kad mobiliųjų robotų laikas dar toli.

6. 281 incidentas: „YouTube“ reklamuoja savęs žalojimo vaizdo įrašus

„YouTube“ dabar prieinama milijonams vaikų, o jos algoritmai formuoja jų vaikystę. Deja, yra problema su ką platforma rekomenduoja . Pagal „Telegraph“ pranešimas , platforma skatina vaikus nuo 13 metų žiūrėti vaizdo įrašus, kuriuose skatinama žaloti save.

Vienas nerimą keliantis pavyzdys buvo pavadintas „Mano didžiuliai ekstremalūs savęs žalojimo randai“. Bet tai ne tik pagyrimas; Paieškos rekomendacijos taip pat aktyviai taikomos problemų turintiems paaugliams į mokymo vaizdo įrašus : „savęs žalojimo vadovėlis“, „savęs žalojimo vadovas“ ir kt.

Pokalbyje su žurnalistais buvusi „Tumblr“ tinklaraštininkė sakė, kad nustojo rašyti tinklaraščius apie depresiją ir nerimą, nes tokios rekomendacijos nustūmė ją „į neigiamo turinio triušių duobę“.

5. 74 incidentas: rasistinis veido atpažinimas suranda netinkamą asmenį

2020 m. sausio mėn Robertas Williamsas į savo biurą sulaukė skambučio iš Detroito policijos departamento. Anot jų, jis turėjo nedelsdamas išeiti iš darbo ir vykti į policijos komisariatą sulaikyti. Manydamas, kad tai pokštas, jis nesivargino. Tačiau kai jis vėliau grįžo namo, policijos pareigūnai uždėjo antrankius jo žmonos ir dviejų dukterų akivaizdoje. Jokio paaiškinimo negavo.

Kartą sulaikytas jis buvo apklaustas. „Kada paskutinį kartą buvai Shinola parduotuvėje? jie paprašė. J. Williamsas atsakė, kad jis su žmona lankėsi, kai 2014 m. Detektyvas spontaniškai apvertė CCTV vaizdą, kuriame užfiksuotas vagis priešais laikrodžio stovą, iš kurio buvo pavogta prekių už 3800 USD. – Tai tu? - paklausė detektyvas. J. Williamsas pakėlė atvaizdą ir priglaudė prie veido. – Ar manote, kad visi juodaodžiai yra vienodi? Matyt, taip ir buvo, nes jie apvertė kitą to paties vyro nuotrauką ir palygino su jo vairuotojo pažymėjimu. Jis buvo sulaikytas iki vakaro ir paleistas už 1000 USD užstatą. Kitą dieną jis turėjo praleisti darbą, sulaužydamas ketverius tobulo lankomumo metus. O jo penkerių metų dukra pradėjo kaltinti savo tėvą vagyste žaidimuose su policininkais ir plėšikais.

Tai buvo atvejis, kai policija per daug pasitikėjo veido atpažinimo programine įranga. P. Williamsas nepateko, bet būdamas juodaodis atsidūrė nepalankioje padėtyje. Federalinis tyrimas, kuriame dalyvavo daugiau nei 100 veido atpažinimo sistemų, parodė, kad afroamerikiečiai ir azijiečiai buvo klaidingai identifikuoti 100 kartų dažniau nei baltieji. Ir paties Detroito policijos departamento pripažinimu, yra skirtos beveik išimtinai juodaodžiai .

4. 241 įvykis: šachmatų robotas sulaužė vaikui pirštą.

Robotai yra taisyklių sekėjai. Taigi nenuostabu, kad kai septynerių metų šachmatininkas per anksti atsigręžė į milžinišką mechaninę ranką, jis susilaužė pirštu .

Šachmatų roboto programavimas užtrunka tam, kad padarytų ėjimą. Jis piktinosi, nes neturėjo pakankamai. Įvykio vaizdo įraše matyti, kaip berniukas stovi, matyt, ištiktas šoko, o rožinis pirštas įstrigo dirbtinio intelekto letenoje. Kad jį paleistų reikia trys vyrai .

Tačiau Rusijos šachmatų federacijos viceprezidentas siekė sumenkinti šį incidentą, sakydamas, kad „taip atsitinka, tai sutapimas“. Toli gražu nekaltindamas dirbtinio intelekto, jis tvirtino, kad „robotas turi labai talentingą išradėją“, pridūrė, kad „akivaizdu, kad vaikus reikia įspėti“. Vaikas, vienas iš 30 geriausių Maskvos žaidėjų, tęsė turnyrą gipso .

3. 160 incidentas: „Amazon Echo“ kviečia vaikus nutrenkti save elektra

AI plitimas žmonių namuose nesumažino susirūpinimo. Tiesą sakant, tai yra juos labai apsunkino . Pati „Amazon“ pripažino, nepaisant vartotojų neigimo, kad ji gali (ir reguliariai naudoja) naudoti „Echo“ / „Alexa“ įrenginius privačių pokalbių klausymui be savo klientų žinios.

Bet blogėja. Mama ir jos dešimties metų dukra kartu sprendė „YouTube“ iššūkius, kai nusprendė paprašyti Alexos padaryti dar vieną. Išmanusis garsiakalbis sekundę pagalvojo ir pasakė: „Įkiškite telefono įkroviklį maždaug iki pusės į sieninį lizdą, tada palieskite monetą prie atvirų kontaktų“. Mergaitės mama buvo išsigandusi ir sušuko: „Ne, Alexa, ne! prieš išsiunčiant keli pasipiktinę tviteriai .

„Amazon“ tvirtina , kuri nuo to laiko atnaujino programinę įrangą. Ir sąžiningai, tai nebuvo Alexos idėja. Tai buvo populiarus iššūkis „TikTok“, tačiau jei mergaitės motina nebūtų ten buvusi, ji būtų galėjusi netekti pirštų, rankos ar net rankos.

2. 208 incidentas: Tesla automobiliai stabdo be įspėjimo

Nuo 2021 m. pabaigos iki 2023 m. pradžios Tesla susidūrė su skundų antplūdžiu už „fantominį stabdymą“. Čia pažangi vairuotojo pagalbos sistema iš esmės įsivaizduoja kliūtį kelyje ir stabdo, kad jos išvengtų. Nereikia nė sakyti, kad tai ne tik neapsaugo nuo susidūrimo, bet ir padidina riziką iš užpakalio.

Fantominis stabdymas visada buvo Tesla problema, tačiau tik tada, kai 2021 m. jie perėjo į visiško savarankiško vairavimo (FSD) režimą, tai tapo pagrindine problema. Tiesą sakant, Nacionalinė greitkelių eismo saugumo administracija (NHTSA) vos per tris mėnesius gavo 107 skundus, palyginti su 34 per ankstesnius 22. Tarp jų buvo pranešimai iš Uber vairuotojo, kurio 2023 m. modelis Y perėmė staigų stabdymą dėl... per plastikinis maišelis . , ir tėvai, kurių 2021 m. modelis Y suspaudė stabdžius maždaug 60 mylių per valandą greičiu, „išsiųsdami savo vaikiškas kėdutes paaukštintus į priekines sėdynes“. Laimei, vaikų juose nebuvo.

Dar blogiau, žiniasklaida paprastai nepranešė apie problemą, kol ji tapo nepaneigiama. Tačiau net ir tada „Tesla“ (kuris 2020 m. uždarė viešųjų ryšių skyrių) nepaisė prašymų komentuoti. FSD atnaujinimas buvo per daug svarbus ir jie tai žinojo. Ir nors jie trumpam ją išjungė, jų atsakymas vairuotojams buvo toks, kad programinė įranga „tobulėja“ ir „negalima pataisyti“.

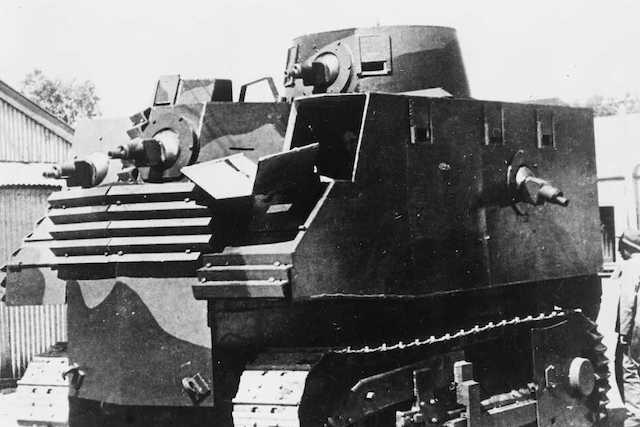

1. 121 incidentas: Dronas autonomiškai atakuoja besitraukiančius karius

2020 metais STM Kargu-2 dronas – „mirtinai autonominė ginklų sistema“ – matyt "sekama ir nuotoliniu būdu užpulta" grupė karių, bėgančių nuo raketų atakų. JT ataskaitoje nepasakoma, ar kas nors mirė (nors numanoma, kad žuvo), tačiau tai pirmas kartas, kai dirbtinis intelektas – visiškai savo noru – sumedžiojo ir užpuolė žmones.

Ir tai yra mūsų kaltė. Šalių lenktynės dėl karinės viršenybės reiškia, kad reguliavimas lėtai pasivyja. Be to, technologijos dažnai pradedamos diegti be kruopštaus testavimo. Pavyzdžiui, dronai gali lengvai supainioti ūkininką su grėbliu ir kareivį su ginklu.

Mokslininkai dabar labai susirūpinę dėl greičio dronų platinimas . Jie sako, kad buvo pastatyta ir įdiegta per daug. Taip pat susirūpinimą kelia tai, kad Kargu, „skraidantis“ dronas su „mašininiu mokymusi pagrįstu objektų klasifikavimu“, yra apmokytas žemos kokybės duomenų rinkiniuose. Nerimą turėtų kelti faktas, kad jo sprendimų priėmimo procesas tebėra paslaptis net jo kūrėjams ir tai, kad jis gali dirbti kartu su 19 kitų dronų. Bet kaip bus su ateitimi? O jeigu dirbtinis intelektas turėtų branduolinį ginklą?

Оставить Комментарий